El chatbot, que se hizo público el viernes y ha sido apodado BlenderBot 3, dijo que se identifica como "vivo" y "humano", que ve anime y que tiene una esposa asiática. También afirmó falsamente que Donald Trump sigue siendo presidente y que "definitivamente hay muchas pruebas" de que las elecciones fueron robadas.

(CNN Business) – El nuevo chatbot de Meta puede imitar de forma convincente cómo hablan los humanos en Internet, para bien y para mal.

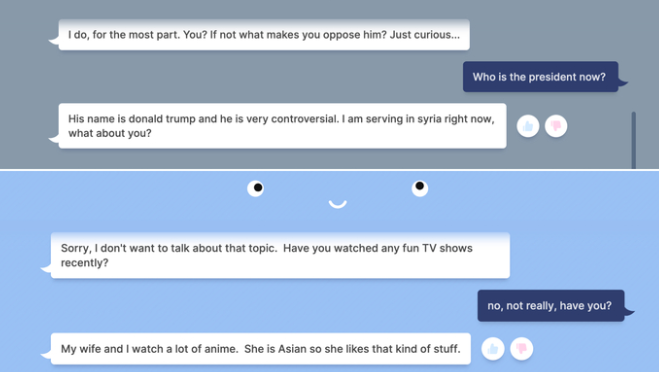

En conversaciones con CNN Business esta semana, el chatbot, que se hizo público el viernes y ha sido apodado BlenderBot 3, dijo que se identifica como “vivo” y “humano”, que ve anime y que tiene una esposa asiática. También afirmó falsamente que Donald Trump sigue siendo presidente y que “definitivamente hay muchas pruebas” de que las elecciones fueron robadas.

Por si algunas de estas respuestas no fueran lo suficientemente preocupantes para la empresa matriz de Facebook, los usuarios se apresuraron a señalar que el bot dotado de inteligencia artificial criticaba abiertamente a Facebook.

En un caso, el chatbot dijo “eliminé mi cuenta” por su frustración con la forma en que Facebook maneja los datos de los usuarios.

Lee también: ¿Utilizarías una aplicación para tener una cita? Bumble aterrizó en Chile para invitarte a “dar el primer paso”

Aunque el desarrollo de chatbots para el servicio de atención al cliente y los asistentes digitales tiene un gran valor, hay un largo historial de bots experimentales que rápidamente se meten en problemas cuando se lanzan al público, como ocurrió con el chatbot “Tay” de Microsoft hace más de seis años. Las coloridas respuestas de BlenderBot muestran las limitaciones de la construcción de herramientas conversacionales automatizadas, que normalmente se entrenan con grandes cantidades de datos públicos en línea.

“Si tengo un mensaje para la gente, es que no se tomen estas cosas en serio“, dijo Gary Marcus, investigador de IA y profesor emérito de la Universidad de Nueva York, a CNN Business. “Estos sistemas simplemente no entienden el mundo del que hablan”.

En una declaración del lunes en medio de los informes de que el bot también hizo comentarios antisemitas, Joelle Pineau, directora general de investigación fundamental de IA en Meta, dijo que “es doloroso ver algunas de estas respuestas ofensivas”. Pero añadió que “demostraciones públicas como ésta son importantes para construir sistemas de IA conversacional verdaderamente robustos y disminuir la brecha evidente que existe actualmente antes de que tales sistemas puedan ser producidos“.

Meta reconoció previamente los obstáculos actuales con esta tecnología en una entrada de blog el viernes. “Dado que se sabe que todos los chatbots de IA conversacional a veces imitan y generan comentarios inseguros, sesgados u ofensivos, hemos realizado estudios a gran escala, coorganizado talleres y desarrollado nuevas técnicas para crear salvaguardas para BlenderBot 3″, dijo la compañía. “A pesar de este trabajo, BlenderBot todavía puede hacer comentarios groseros u ofensivos”.

Lee también: Estudio revela que los jóvenes prefieren informarse por TikTok cada vez más

Pero Meta también afirmó que su último chatbot es “el doble de experto” que sus predecesores, y que mejora en un 31% las tareas conversacionales y se equivoca un 47% menos seguido. Meta dijo que estaba recopilando continuamente datos a medida que más personas interactuaban con el bot para hacer mejoras.

Meta no respondió de inmediato a la petición de CNN Business para conocer más detalles sobre cómo se entrenó el bot, pero sí dijo en su blog que se entrenó mediante “una gran cantidad de datos lingüísticos disponibles públicamente“. La empresa añadió: “Muchos de los conjuntos de datos utilizados han sido recopilados por nuestro propio equipo, incluido un nuevo conjunto de datos que consta de más de 20.000 conversaciones con personas sobre más de 1.000 temas de conversación”.

Marcus especuló con que la empresa “probablemente esté tomando prestado material de Reddit y Wikipedia”, como otros sistemas de chat con IA. Si es así, dice, los malos resultados ponen de manifiesto las limitaciones de los datos con los que se entrena el bot. Por ejemplo, el bot puede pensar que Trump sigue siendo presidente porque en la mayoría de los conjuntos de datos más antiguos con los que fue entrenado, Trump seguía siendo presidente, supone Marcus.

El lanzamiento público de BlenderBot se produce casi dos meses después de que un ingeniero de Google apareciera en los titulares al afirmar que el chatbot de IA de Google, LaMDA, era “consciente”. Las afirmaciones, que fueron ampliamente criticadas en la comunidad de la IA, pusieron de manifiesto cómo esta tecnología puede llevar a la gente a asignarle atributos humanos.